产品世界

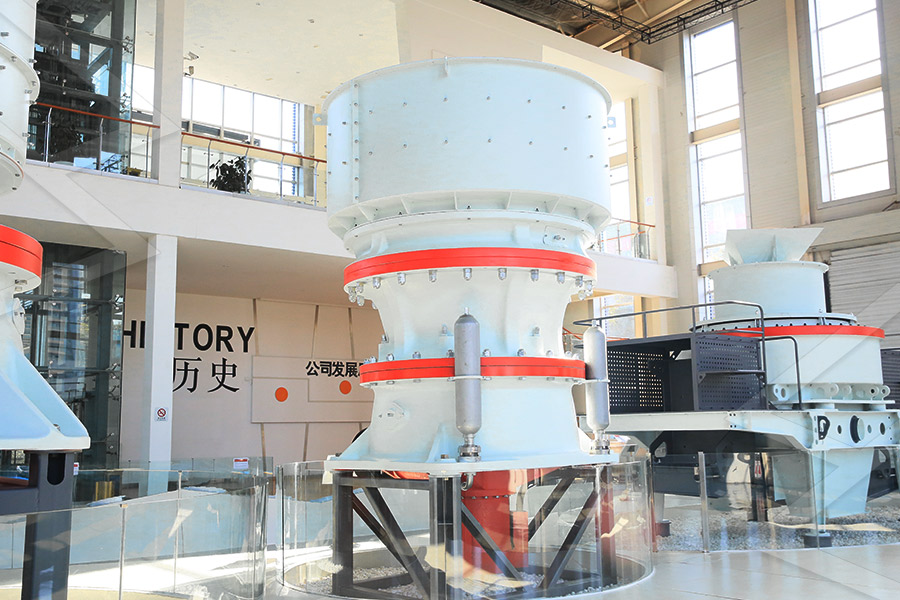

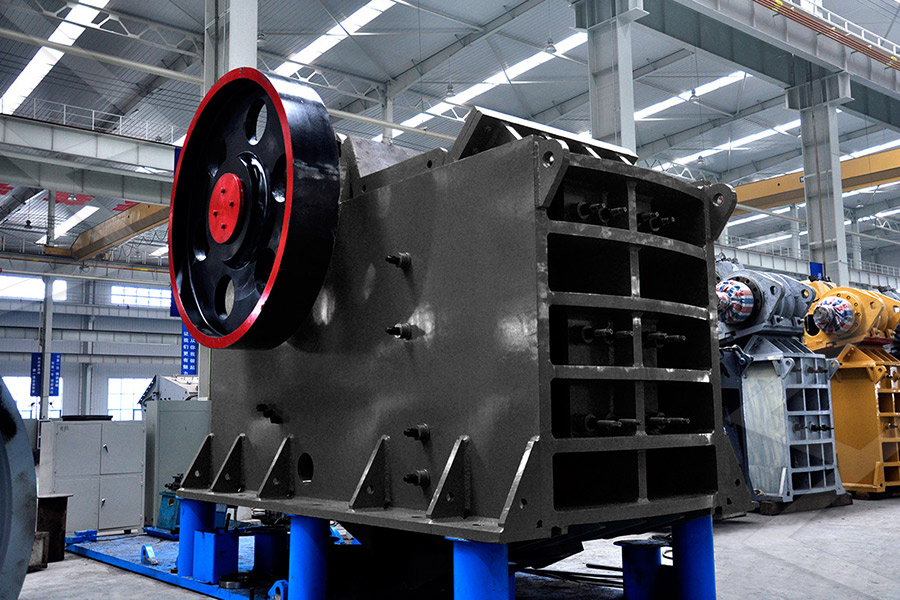

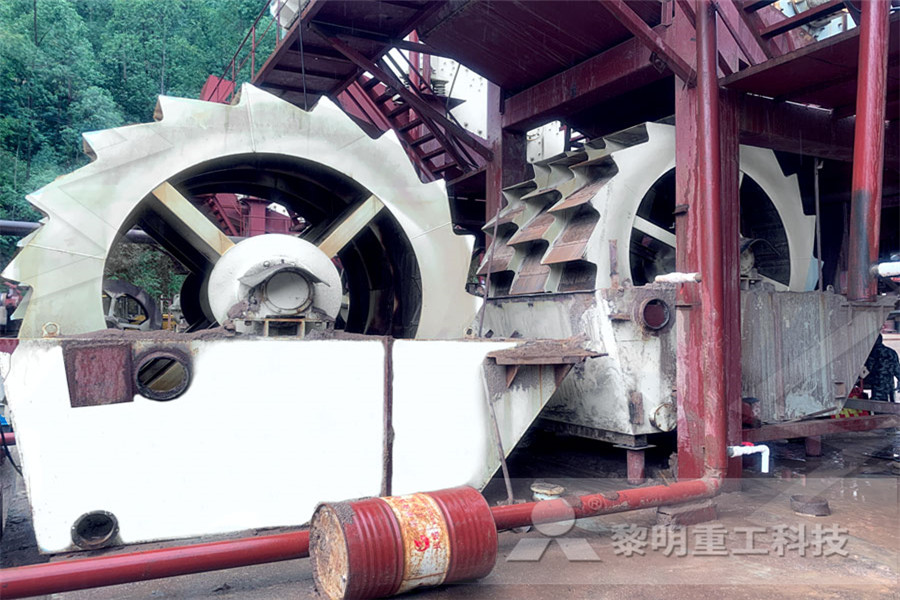

产品系列完备,打通粗碎、中碎、细碎和超细碎作业

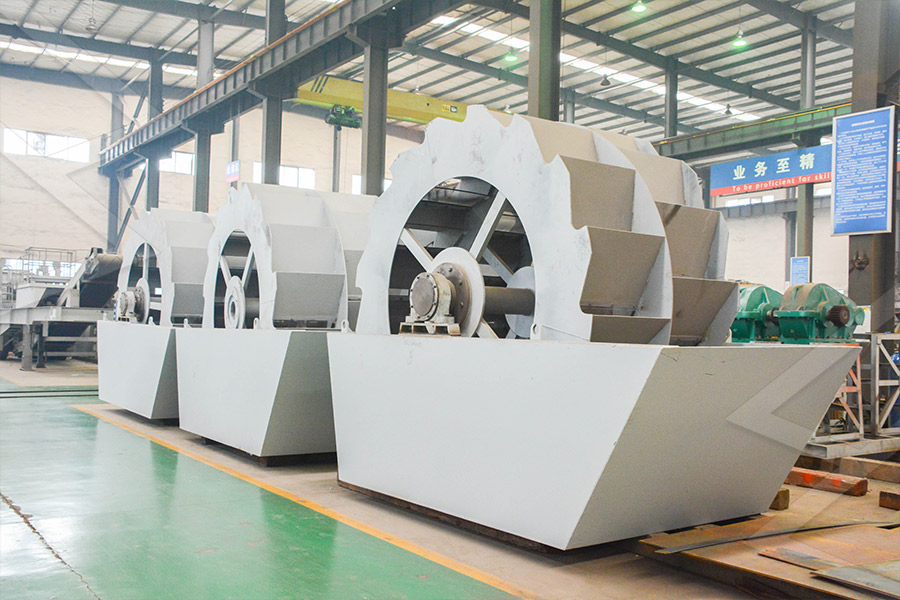

VSI家族与VU骨料优化系统共担精品机制砂制备重任

130b圆锥破碎机参数

2022-05-02T05:05:14+00:00

2022-05-02T05:05:14+00:00

圆锥破碎机的主要参数 百度文库

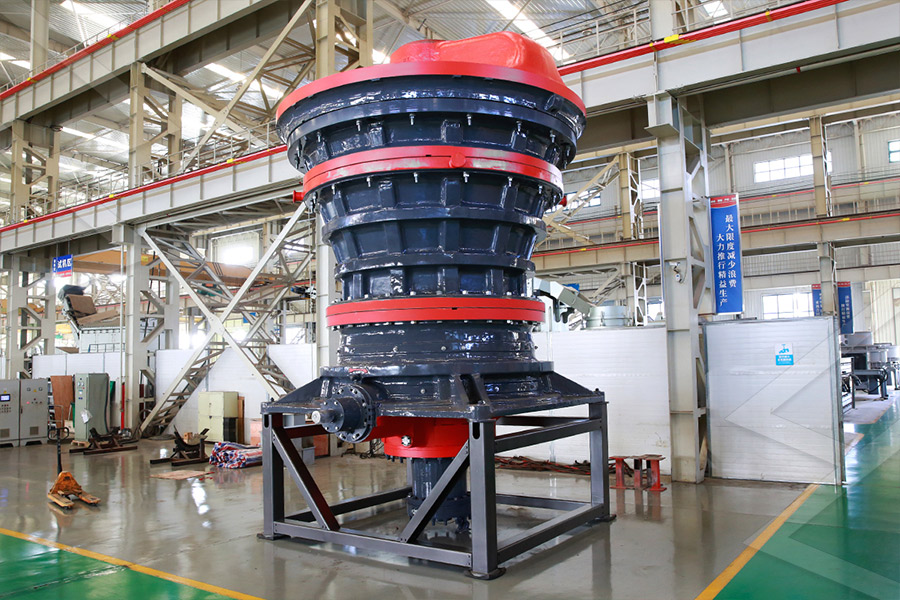

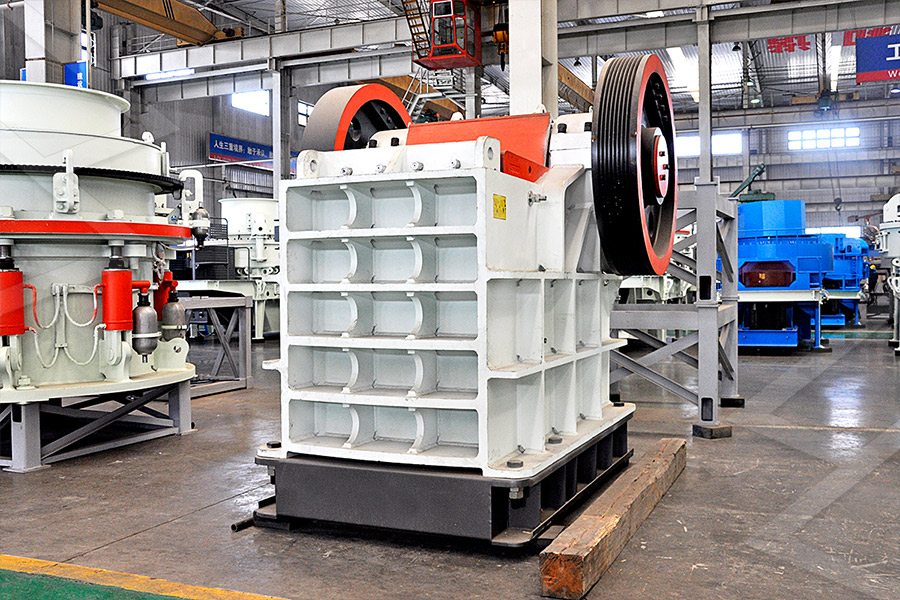

圆锥破碎机的主要参数 圆锥破碎机的主要参数 1给料口和排料口宽度圆锥破碎机的给料口宽度B= (12~125)D,其中D为 给料粒度,由选矿流程而定。 排料口宽度取决于所要求的 2023年9月4日 1300圆锥破碎机是复合型圆锥破碎机中一款型号,适用于中等和中等以上硬度的各种矿石和岩石,破碎比大、处理量高,排矿口调节方便、使用经济,关于其产量 1300圆锥破碎机参数配多大颚破?河南红星机器PYB圆锥破碎机 一款中细碎破碎机设备,弹簧既是保险装置又影响破碎力。 破碎腔形式是由矿石用途决定的:标准型适于中碎;中型适于中细碎;短头圆锥破碎机适于细碎。 适用 PYB圆锥破碎机 价格及规格型号参数 选矿设备

圆锥破碎机技术参数 百度文库

圆锥破碎机的技术参数是影响其破碎效率和生产能力的重ቤተ መጻሕፍቲ ባይዱ因素。 在选择圆锥破碎机时,需要根据物料的性质和生产需求来确定合适的型号和参数。 2 进料口尺 立刻获取报价 进料粒度 ≤220mm 破碎能力 36~455t/h 电机功率 200kw 1300圆锥破碎机属于SDY弹簧圆锥破碎机中的一种型号,有SDY1300B,SDY1300D两种规格,粗中细等 1300圆锥破参数SDY1300B/D弹簧圆锥破碎机中誉鼎力河南 圆锥破碎机主要用在破碎中段、采矿破碎段、骨料破碎生产段等。应用行业也很广泛,在矿山、冶金、水泥厂、砂石厂、石子厂、建筑垃圾处理厂中都适用。 圆锥破碎机经过一次次的更新,有很多型号。有单缸圆锥破碎 圆锥破碎机型号详解,重型圆锥破碎机如何选择Zh 知乎

hp300圆锥破碎机每小时产多少吨?型号及参数说明

2021年9月17日 hp300圆锥破型号属于多缸液压圆锥破碎机,采用新型技术研发而成,转速高产量大,转速达410转每分,提升破碎效率,单台每小时产120445吨,电机功 glm130b(1300亿)为例 现在GLM130B这个大模型参数量在1300亿,假设每个参数都是一个 fp32,即 4 个字节,总字节就是 5200 亿字节,则 5200亿字节/1024/1024 = 480GB,当然这是原始的理论值,我们再往下看。大模型参数量和模型大小怎么换算? 知乎总结 三大挑战:大、慢、迁移低效 已经出现了一大批候选的可能方案 大:模型压缩 蒸馏:压缩比极高,目前理解型任务适用,但生成型不太适用 量化:压缩比在25%左右,保持原有模型几乎全部性能 慢:底层优化+ 大模型低资源部署应用与挑战 知乎

深入PCI与PCIe之一:硬件篇 知乎

深入PCI与PCIe之一:硬件篇 PCI总线和设备树是X86硬件体系内很重要的组成部分,几乎所有的外围硬件都以这样或那样的形式连接到PCI设备树上。 虽然Intel为了方便各种IP的接入而提出IOSF总线,但是其主体接口 在本节中,讨论了 GLM 和其他预训练模型之间的区别。 主要关注的是它们如何适应下游的空白填充任务。 与 Bert 对比 :BERT 是一种基于自编码的模型,它通过 mask 输入文本中的一些单词,然后训练模型去预测 mask 的单词,这种目标叫做掩码语言模型(MLM 清华大学通用预训练模型:GLM 知乎表示方法 IPv6 : IPv6的地址长度为128位,是IPv4地址长度的4倍。 公网IPIP地址是由IANA统一分配的,以保证任何一个IP地址在Internet上的唯一性。这里的IP地址是指公网IP地址。 私网IP实际上一些网络不需要连接到Internet,比如一个大学的封闭实验室内的网络,只要同一网络中的网络设备的IP 一篇搞定IP地址(IP划分、IP地址计算、子网掩码、子

论文阅读GLM130B:一种开放的双语预训练模型(2023

1 介绍 GLM130B是一个双语(英语和汉语)预训练的语言模型,具有1300亿个参数。 GLM130B模型的性能显著优于GPT3175B(davinci),而在OPT175B和BLOOM176B中没有观察到性能优势。 在相关基准测试中,它也始终显著优于较大的中文模型ERNIE TITAN 30 260B。 利用GLM130B 20220419 PCIe 是如何实现 Block Type 检测的? Block Type 检测是检测当前数据流为 Ordered Set Block 还是 Data block,是 PCIe Gen3 及以上的概念,因为 Gen3 时才出现 Ordered Set Block 与 Data Block 之分。 Block Type 检测原理很简单,就是根据同步头中的两个 bit 进行判断,但在判断 【毅力挑战】PCIe 每日一问一答(202204 归档)阿里云 2023年6月2日 简介 我们介绍了GLM130B(general launguage model 1300亿参数),这是一个拥有1300亿参数的双语(英文和中文)预训练语言模型。 这是一次尝试开源至少与GPT3一样优秀的1000亿级模型,并揭示这样规模的模型如何成功进行预训练的方法。 在此过程中,我们面临许多 GLM130B:一个开源的中英文预训练大模型 知乎

PCIe扫盲——ReTimer和ReDriver简介 知乎

2023年6月19日 有两种信号调节功能的器件: ReTimer, ReDriver ReDriver功能相对简单,其通过Rx端的CTLE(基本原理一般就是一个高通滤波器),和Tx端的驱动器,实现对损耗的补偿,进而使得眼图的窗口变大,让整个PCIe通道看起来有更小的衰减。 由于ReDriver有没涉及到任何协议 比如,GLM 130B只过了400B数据,它的训练计算量(flops)是不如过了14T数据的llama65B和过了2T数据的llama 2 70B的。 模型参数量只是给大家一个相对的概念,但当数据量有限或者固定的前提下,肯定是越大越好。【LLM系列】多大的参数才算大模型关于“大”模型的 22 IPv6有哪些特点,是如何解决IPv4的各个问题的? 地址数量巨大 IPv6采用128位的地址空间,总地址数量是2的128次方,理论上可以说地址数量近乎无限。 IPv6可以给地球上的每粒沙子都分到1个地址 提高网络性能 一文看懂IPv6 知乎

复刻ChatGPT语言模型系列(一)基座模型选取 知乎

400B的Token,但是据估计130B模型需要4T的Token; GLM130B FP16需要260G显存存储模型权重; UniLM 许多人指出GLM和UniLM的模型结构非常相似。下面将对UniLM的模型结构进行详细介绍。 UniLM是微软研究院 2023年1月1日 注意:简洁起见,本章后续中使用锁定(Lock)一词表示已经完成了比特锁定和 8b/10b 编码的符号锁定、或者 128b/130b 编码的块锁定。 接收端必须首先完成比特和符号或者块的锁定操作之后,才能在链路 [译文]《PCI Express Technology 30》Chapter 14 Link glm130b glm130b 是一个开源开放的双语(中文和英文)双向稠密模型,拥有 1300 亿参数,模型架构采用通用语言模型(glm)。它旨在支持在一台 a100(40g * 8)或 v100(32g * 8)服务器上对千亿规模参数的模型进行推理。2023 年热门的大型语言模型 (LLMs)汇总 知乎

大模型分布式训练并行技术(六)多维混合并行 知乎

2023年10月14日 具体来说,GLM130B 模型含有 70 层 Transformer,隐层维度 12,288,较大序列长度 2,048,以及一个基于 icetk 的 150,000 个标识符的双语分词器。 它的预训练目标由两部分组成:部分(95%)是自监督的预训练,即在公开的大规模语料库以及其他一些较小的中文语料库上的自回归空白填充。2023年9月13日 CLiB中文大模型能力评测榜单(持续更新) 深度学习,NLP算法,产品经理,文艺青年 目前已囊括48个大模型,覆盖chatgpt、gpt4、谷歌bard、百度文心一言、阿里通义千问、讯飞星火、360智脑、商汤senseChat、微软newbing、minimax、tigerbot等商用模型, 以及百川、belle CLiB中文大模型能力评测榜单(持续更新) 知乎专栏从 Gen 3 开始,NonFlit 模式下编码方式变成了 128b/130b。保留了下图的帧令牌,因为通过 130b 的同步头划分了严格的数据流类型和有序集类型,所以增加了 EDS 帧令牌,告知接收器数据流发送结束;删掉了 END 帧令牌改为 EDB 帧令牌,EDB 表明前面的 TLP 是有问题 PCIe 物理层总结 2 有序集、帧令牌和 Flit 知乎

ChatGLM6B 实践分享 知乎

glm130b的官网上对glm130b的预训练介绍算是比较详细的了。这里也简单介绍一下。 (截至2022年7月31日,训练glm130b遇到和解决的主要问题的时间轴) glm130b的预训练使用了超过4000亿个文本标记。包含自监督预训练语料 一、简介 我们介绍GLM130B,一个具有1300亿个参数的双语(英文和中文)预训练语言模型。 它试图开源一个至少与GPT3(davinci)一样好的100B规模的模型,并揭开如此规模的模型如何能够成功预训练的面纱。 在这一努力过程中,我们面临许多意想不到的技术和 glm130b:一个开放的双语预训练模型 知乎1 背景:论文: 知乎 安全中心github: THUDM/ChatGLM6B目前已经存在各种类型的预训练架构,包括自编码模型(例如BERT),自回归模型(例如GPT),以及编码器解码器模型(例如T5)。然而,在自然语言理解(NL预训练大模型解析:GLM 知乎

【PCIe】PCIe速率与带宽计算 知乎

2023年10月17日 而PCIe 30 的物理层协议中使用的是 128b/130b 的编码方案。 即每传输128个Bit,需要发送130个Bit。 那么, PCIe 30协议的每一条Lane支持 8 * 128 / 130 = 7877 Gbps = 9846 MB/s 的速率。 一个PCIe 30 x16的通道,x16 的可用带宽为 7877 * 16 = 126031 Gbps = 15754 GB/s。前言 PCIe 50 第5代PCIe技术PCIe50速度是 PCIe 40 的两倍,并具有向下兼容性。PCIe 50 协议分析仪能够支持 32GT/秒的数据链路速度操作,同时具有卓越的内存、存储容量和分段功能,可捕获更大容量的上行和下行第5代PCIe技术——PCIe 50 知乎2023年7月23日 性能的定义 PCIe GEN1较大传输速率是25Gbps,PCIe GEN2较大传输速率是5Gbps,PCIe GEN3较大传输速率是8Gbps。 这些速率只的是raw bit传输速率,并不是系统的有效data传输速率。 有效的数据传输速率因为overhead要比此低。 各种类型的数据,例如内存、I/O 或配置数据,通过 理解PCIe的性能 知乎

来自清华的ChatGPT?GLM130B详解CSDN博客

2023年5月12日 本次介绍了GLM130B的训练过程,包括其设计选择、效率和稳定性的训练策略以及工程努力。 在广泛的流行英语测试中,GLM130B模型的性能显著优于GPT3175B,而在OPT175B和BLOOM176B中没有观察到性能优势。 在相关测试中,它也始终显著优于较大的中文模型ERNIE TITAN 3 正是由于这两种酶的底物和发光颜色不同,所以在双荧光素酶报告实验中得到广泛应用,它们的发光原理如下所示: 实验原理 4Firefly luciferase和Renilla luciferase之所以被称为报告基因,是因为在基因表达调控研究时,利用两者表达产生的荧光比值可以监控、证实 双荧光素酶报告(DualLuciferase Reporter)实验介绍 知乎2023年6月12日 腾讯技术工程 本文首先从训练数据、tokenizer 和模型结构细节上对比了 LLaMA、ChatGLM 和 BLOOM 这三个主流的开源大语言模型,并介绍了这三个基座模型的衍生模型;接着详细介绍了不同大语言模型在 tokenizer、layer normalization、激活函数和位置编码的模型细节;然后 大语言模型LLaMA, ChatGLM, BLOOM 的高效参数微调实践 知乎

【自然语言处理】【大模型】GLM130B:一个开源双语预

具体来说,GLM130B是一个具有1300亿参数的双语双向稠密模型,其在96个NVIDIA DGX100 (8*40G)节点的集群上用400B的token进行了预训练,训练从2022年5月6日至2022年7月3日。 相比于使用GPT风格的架构,我们采用General Language Model (GLM)算法来利用双向注意力优势和自回归空白 2018年11月14日 2022年11月,在斯坦福大学大模型中心对全球30个主流大模型的评测报告中,GLM130B 在准确性和恶意性指标上与 GPT3 175B (davinci) 接近或持平,鲁棒性和校准误差在所有千亿规模的基座大模型(作为公平对比,只对比无指令提示微调模型)中表现不 LLMs模型速览上(GPTs、LaMDA、GLM/ChatGLM、PaLM/Flan 2023年4月25日 初步整理了开源中文LLM的情况,进行分享, 后续会不断更新。需要注意的是,每个模型的介绍,主要都是基于他们自己的材料。ChatGLM(当前只有ChatGLM6B开源)应该是清华大学实验室和智普AI合作的。 ChatGLM:千亿基现有开源中文LLM整理(更新) 知乎

如何分配和申请IPv6地址? 知乎

今天为大家讲解IPv6技术知识—如何分配和申请IPv6地址? IPv6地址表示 IPv6地址总长度为128比特,通常分为8组,每组为4个十六进制数的形式,每组十六进制数间用冒号分隔。 例如:FC00:0000:130F:0000:0000:09C0:876A:130B,这是IPv6地址的首选格式。 但是128位地址表示 图1:清华开源的ChatGLM130B大模型 这些大公司或者研究机构,都是有足够资源的来开发大模型,但是对于一般的小公司或者个人来说,要想开发自己的大模型几乎不可能,要知道像 ChatGPT 这样的大模型,一次训 LORA:大模型轻量级微调 知乎通过ChatGPT + pinecone向量数据库来做,将你的私有知识都存在向量数据库中,然后对你数据做语义查询。 大家都知道chatgpt预训练完成后,会生成一个embeddings向量字典,我们可以将这个利用起来。 比如我们可以将我们的私有 知识库 各个章节通过openai的相关api ChatGPT怎么建立私有知识库? 知乎

ChatGLM 部署 知乎

2023年5月20日 3、PTuning v2微调ChatGLM6B ChatGLM团队自身也出了一个基于PTuning v2的方式微调ChatGLM6B的项目:ChatGLM6B 模型基于 PTuning v2 的微调 PTuning v2(代码地址,论文地址)意义在于:将需要微调的参数量减少到原来的 01%,再通过模型量化、Gradient Checkpoint 等方法,最低只需要 7GB 显存即可运行接收端PCIe设备(即Completer)的物理层接收到数据之后,依次执行与发送端相反的操作。 并从数据中恢复出时钟,然后将恢复出来的DLLP发送至数据链路层。 如果存在错误,则向Requester发送一个Nak类型的DLLP,该DLLP包含了其接受到的DLLP中的序列号(Sequence Number pcie的访问流程? 知乎2023年8月10日 其中,min max 字段为该数据类型可表示的较大最小值。 tiny 和 smallestnormal 含义相同,表示该数据类型可以表示的最小正数。 eps 字段为该数据类型的最小可表示数,满足 10 + eps != 10 。 resolution 数据类型对应的近似十进制精度。 可以看到,虽然精度比 float16 要差很多,但 bfloat16 数据类型拥有和 为什么很多新发布的LLM模型默认不用float16呢? 知乎

国产ChatGPT(ChatGLM)的个商业化应用:代审合同

2023年4月24日 昨天看了一个新闻: 智谱AI与电子签约SaaS提供商上上签合作,在智谱AI自研的千亿参数大模型GLM130B基础上,上上签打造了签约智能产品Hubble哈勃。据介绍,这是电子签约行业首款应用了大模型技术的生成式AI产品,2023年5月29日 文章浏览阅读28k次,点赞6次,收藏25次。2022年11月,斯坦福大学大模型中心对全球30个主流大模型进行了全方位的评测[2],GLM130B 是亚洲唯一入选的大模型。在与 OpenAI、谷歌大脑、微软、英伟达、脸书的各大模型对比中,评测报告显示 GLM130B 在准确性和恶意性指标上与 GPT3 175B (davinci) 接近或持平 清华大学chatGLM论文解读CSDN博客综上所述,BMInf 已支持将 GLM130B 运行在 8 卡 V100 服务器。未来我们也希望测试 BMInf 与 GLM 130B 在其他服务器配置上的性能,欢迎感兴趣的研究人员与开发者加入OpenBMB 开源社群,一起体验千亿大模型的魅力,共同探讨大模型的落地与普及之路。 传送门|GitHub 链接 突破显存墙,BMInf现已支持GLM130B 知乎

ChatGLM:一个开源的中英双语大语言模型 知乎

2023年5月22日 为了解决这个问题,清华大学数据挖掘实验室(THUDM)推出了一个开源的中英双语对话语言模型:ChatGLM。 ChatGLM 是一个基于千亿基座模型 GLM130B 开发的对话机器人,具有问答、多轮对话和代码生成功能。 目前,ChatGLM 有两个版本:千亿参数的 ChatGLM(内测版 2023年6月1日 基于 ChatGLM6B 部署本地私有化 ChatGPT 优化的模型架构和大小: 吸取 GLM130B 训练经验,修正了二维 RoPE 位置编码实现,使用传统FFN结构。 6B(62亿)的参数大小,也使得研究者和个人开发者自己微调和部署 ChatGLM6B 成为可能。 最近chatGPT很火,但是用起来需要翻 基于 ChatGLM6B 部署本地私有化 ChatGPTglm130b(1300亿)为例 现在GLM130B这个大模型参数量在1300亿,假设每个参数都是一个 fp32,即 4 个字节,总字节就是 5200 亿字节,则 5200亿字节/1024/1024 = 480GB,当然这是原始的理论值,我们再往下看。大模型参数量和模型大小怎么换算? 知乎

大模型低资源部署应用与挑战 知乎

总结 三大挑战:大、慢、迁移低效 已经出现了一大批候选的可能方案 大:模型压缩 蒸馏:压缩比极高,目前理解型任务适用,但生成型不太适用 量化:压缩比在25%左右,保持原有模型几乎全部性能 慢:底层优化+ PCI总线和设备树是X86硬件体系内很重要的组成部分,几乎所有的外围硬件都以这样或那样的形式连接到PCI设备树上。虽然Intel为了方便各种IP的接入而提出IOSF总线,但是其主体接口(primary interface)还依然是PCIe形深入PCI与PCIe之一:硬件篇 知乎在本节中,讨论了 GLM 和其他预训练模型之间的区别。 主要关注的是它们如何适应下游的空白填充任务。 与 Bert 对比 :BERT 是一种基于自编码的模型,它通过 mask 输入文本中的一些单词,然后训练模型去预测 mask 的单词,这种目标叫做掩码语言模型(MLM 清华大学通用预训练模型:GLM 知乎

一篇搞定IP地址(IP划分、IP地址计算、子网掩码、子

表示方法 IPv6 : IPv6的地址长度为128位,是IPv4地址长度的4倍。 公网IPIP地址是由IANA统一分配的,以保证任何一个IP地址在Internet上的唯一性。这里的IP地址是指公网IP地址。 私网IP实际上一些网络不需要连接到Internet,比如一个大学的封闭实验室内的网络,只要同一网络中的网络设备的IP 1 介绍 GLM130B是一个双语(英语和汉语)预训练的语言模型,具有1300亿个参数。 GLM130B模型的性能显著优于GPT3175B(davinci),而在OPT175B和BLOOM176B中没有观察到性能优势。 在相关基准测试中,它也始终显著优于较大的中文模型ERNIE TITAN 30 260B。 利用GLM130B 论文阅读GLM130B:一种开放的双语预训练模型(2023 20220419 PCIe 是如何实现 Block Type 检测的? Block Type 检测是检测当前数据流为 Ordered Set Block 还是 Data block,是 PCIe Gen3 及以上的概念,因为 Gen3 时才出现 Ordered Set Block 与 Data Block 之分。 Block Type 检测原理很简单,就是根据同步头中的两个 bit 进行判断,但在判断 【毅力挑战】PCIe 每日一问一答(202204 归档)阿里云

GLM130B:一个开源的中英文预训练大模型 知乎

2023年6月2日 简介 我们介绍了GLM130B(general launguage model 1300亿参数),这是一个拥有1300亿参数的双语(英文和中文)预训练语言模型。 这是一次尝试开源至少与GPT3一样优秀的1000亿级模型,并揭示这样规模的模型如何成功进行预训练的方法。 在此过程中,我们面临许多 2023年6月19日 有两种信号调节功能的器件: ReTimer, ReDriver ReDriver功能相对简单,其通过Rx端的CTLE(基本原理一般就是一个高通滤波器),和Tx端的驱动器,实现对损耗的补偿,进而使得眼图的窗口变大,让整个PCIe通道看起来有更小的衰减。 由于ReDriver有没涉及到任何协议 PCIe扫盲——ReTimer和ReDriver简介 知乎比如,GLM 130B只过了400B数据,它的训练计算量(flops)是不如过了14T数据的llama65B和过了2T数据的llama 2 70B的。 模型参数量只是给大家一个相对的概念,但当数据量有限或者固定的前提下,肯定是越大越好。【LLM系列】多大的参数才算大模型关于“大”模型的

集团新闻

往房上吊粮食的机器

2020-12-11日产1000吨钴方解石制砂机器

2023-08-15十二五节能环保产业发展规划

2021-08-04MFJ反击式破碎机

2023-03-30广东给料机喂料机

2023-05-08常熟天隆机械

2022-01-05固体废物破碎机图片

2020-10-03四川弹簧圆锥破碎机120型

2023-04-06山西产的矿用破碎机

2023-10-051800TPH环锤式破碎机

2022-01-25切割混凝土机器切割混凝土机器切割混凝土机器

2021-07-13如何申请办理重点工程黎明性采石场

2023-12-01砂石生产线设备网购

2020-04-08复摆鄂式破碎机PE870x10

2022-09-27矿石制样粉碎机

2022-08-04叶岩生产线工艺流程叶岩生产线工艺流程叶岩生产线工艺流程

2023-09-22钴土配套设备

2020-10-28圆锥破外形尺寸

2021-03-09磨料用立式冲击破碎机,冲击式破碎机

2022-03-05膨润土原料

2020-03-18煤立磨的工艺流程介绍图

2023-10-28矿山大型设备

2022-10-27浮选厂成本核算

2021-12-09采石场业务范围采石场业务范围采石场业务范围

2023-04-03大型综采液压支架在复杂煤层中的应用

2020-10-26采石场盐沙场须要什么手续费用

2022-07-26采石场资金

2021-06-30磨砂机传送带

2020-09-29锂矿破碎工艺锂矿破碎工艺锂矿破碎工艺

2022-03-17生产彩砂要啥设备

2022-11-17